自動文本摘要 – 林肯,自動摘要簡介 – 數據博客

有關數據,人工智能和我的項目的博客

Contents

自動摘要是要使用長文本,甚至是一組文本,並自動生成一個較短的文本,其中包含大多數信息. 簡單的 ? 沒有那麼多. 首先,您必須同意哪些信息真正重要. 然後,我們必須能夠正確提取它們,重組它們. 這是不計算大量可能摘要的大量變體 !

自動文本摘要

隨著紋理收集和存儲的爆炸式增長,從質量中分析和提取相關信息的需求越來越出現.

此外,自動自然語言處理(TALN)的深度學習模型中的繁榮促進了在操作問題中使用文本數據. 自動文本摘要與回答問題相同,相似性分析,文檔的分類和與鏡有關的其他任務是這些問題的一部分.

正是在這種情況下 實驗室創新 德·林肯(De Lincoln)已決定在自動文本摘要上進行工作. 這些作品使建立可用於語言的自動摘要模型的基準是可能的 法語, 引起我們自己的模型並最終將其投入生產.

��模型培訓

數據

在開始工作之前,我們首先必須構建一個數據庫來學習自動摘要模型. 我們已經從幾個法國新聞網站中收回了新聞稿. 該基礎包含〜60k文章,並不斷更新.

最先進的

自動摘要算法可以分為兩類:摘要 挖掘 和摘要 抽象. 在框架中 挖掘, 這些摘要是根據從文本中提取的句子構建的,而摘要 抽象 是由新句子生成的.

自動摘要模型在英語中很常見,但在法語中卻少得多.

指標

對於模型的評估,我們使用以下指標:

紅色的 : 毫無疑問,在摘要任務中最常報告的測量值是召回評估的召回研究(Lin,2004年),計算了評估的摘要與人類參考摘要之間的相似n-gram數量.

流星: 用明確訂購評估翻譯的指標 (Banerjee和Lavie,2005年)設計用於評估自動翻譯結果. 它基於精確的諧波平均值和召回統一的召回,召回的權重大於精度. 流星經常用於自動摘要出版物(參見等人., 2017; Dong等., 2019年),除了紅色.

新奇: 已經註意到,某些抽像模型過於太多的提取(參見等人., 2017; Krysci’nski等人.‘,2018年). 因此,測量生成的摘要中產生的新N-gram的百分比已成為常見.

資料來源:MLSUM紙的翻譯[2].

模型的部署

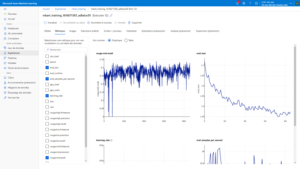

對於模型培訓,我們使用了Cloud Azure ML服務,為培訓,監視和部署模型提供了一個完整的環境.

我們更精確地使用了Python SDK,它使您可以以程序化的方式管理整個Azureml環境,從啟動“作業”到模型的部署.

但是,我們將最終模型封裝在容器化的燒瓶應用程序中,然後通過kubernetes群集上的CI/CD管道部署

結果

首先,我們進行了幾次嘗試,在10K文章上領先模型,改變了模型開頭(512或1024)和不同架構的代幣數量.

第一個觀察:紅色和流星指標似乎不適合我們模型的性能評估. 因此,我們選擇僅基於新穎得分並選擇的比較 建築學 贊成更抽象的摘要.

在將模型對700K項目進行了訓練之後,我們大大改善了結果並驗證了您將在下面找到的第一個版本.

注意點

除了表演之外,該實驗使我們能夠突出一些 邊界 自動摘要:

當前,類型模型輸入中文本的大小 轉換 受GPU的記憶力的限制. 內存的成本是二次的文本大小作為輸入,這對自動摘要的任務構成了一個真正的問題,在該任務中,要摘要的文本通常足夠長.

很難找到相關的指標來評估文本生成任務.

當心 提取器的重量 :我們還遇到了與數據有關的幾個問題. 主要問題是,本文的文章通常是釋義的,甚至是本文的第一句句子的重複. 這是由於簡單地返回文章的第一句話來鼓勵我們的模型比抽象更具抽象性更具提取性. 因此,有必要通過刪除提出問題的文章來避免這種偏見來進行策劃工作.

有關數據,人工智能和我的項目的博客.

自動摘要是要使用長文本,甚至是一組文本,並自動生成一個較短的文本,其中包含大多數信息. 簡單的 ? 沒有那麼多. 首先,您必須同意哪些信息真正重要. 然後,我們必須能夠正確提取它們,重組它們. 這是不計算大量可能摘要的大量變體 !

在我的博士學位之前,我能夠在這個令人興奮的主題上工作大約一年,因此,這篇文章是我沉浸在這個主題中的機會,並盤點域名的最新創新.

因此,讓我們概述該主題,通過描述存在的不同類型的摘要來詳細介紹兩種類型的系統之前:來自AI和神經網絡的摘要,以及那些相當專注於最佳提取的系統。信息.

不同類型的摘要

當我們談論摘要時,我們經常想到一本書的封底或電影的劇本描述. 通常,它們避免破壞終點,當這正是人們要求的經典自動摘要工具時:告訴概述,摘要可能足以了解必需品. 這是關於 單案摘要, 也就是說,我們只概括了一個文檔(電影,一本書,一篇文章,…).

相反,我們可能想要一個 多文獻摘要, 在新聞評論的背景下,我們會更頻繁地開會:我們想摘要各種新聞機構報告的最重要信息.

一旦我們決定了要概述的數據類型,單聲道或多紀錄片,我們就可以選擇兩種方法:挖掘, 它包括提取在將信息放回以創建摘要之前提取的信息,而方法 生成, 它包括創建最初在文檔中不出現的新句子,以便有更多的流動性和更自由的摘要.

除了這些標準外,還有各種摘要的樣式,我們在這裡不會使用:更新摘要包括總結新文檔中出現的信息,並且到目前為止尚未列出的信息,該摘要指示的摘要包括精確的角度。由用戶給予..

人工智能和神經網絡徹底改變了自動摘要

直到2010年代中期,大多數摘要都是挖掘的. 但是,這些算法中已經存在了巨大的多樣性,這些算法的範圍可能從整個句子的選擇和提取到提取精確信息的提取,然後再在帶有預先準備的孔的文本中,稱為模板. 基於神經網絡的新方法的到來已經發生了很大的改變. 這些算法比以前的算法更有效地產生語法和流體文本,例如使用此GPT演示可以做的事情.

但是,神經網絡需要大量的數據進行培訓,並且相對不舒服. 它們完美地生成了對真實性的評論,這並不重要,但是強烈產生矛盾或簡單的信息,這在新聞文章的背景下是有問題的,例如. 許多研究文章對神經網絡的這些“幻覺”感興趣.

混合工具的一個示例:Potara

自動摘要是我感興趣的第一個研究主題,我有機會在我的主人期間開發了一個由提取/生成的混合系統摘要,以採用多文件方法,也就是說,總結一組文檔在講話。同一主題.

這個想法是從經典提取開始,即確定最重要的句子並組裝它們以產生摘要. 這種方法的問題在於,最重要的句子通常可以進一步改善. 例如,在一篇關於總統流離失所的文章中,“伊曼紐爾·馬克龍(Emmanuel Macron)遇到了他的美國同行並討論了經濟學”一詞,可以改善“伊曼紐爾·馬克龍( Emmanuel Macron)遇見喬·拜登(Emmanuel Macron),討論了喬·拜登(Joe Biden)並討論了經濟”。. 記者小心地避免彩排,我們發現自己經常面對這種現象.

為了克服此缺陷,我們可以識別出不同文檔中存在的類似句子,並嘗試將其合併以獲得更好的句子. ANSI,從以下兩個句子中:

- 伊曼紐爾·馬克龍(Emmanuel Macron)在華盛頓遇到了他的美國同行,並詳細談論了經濟學.

- 法國總統遇到了喬·拜登(Joe Biden)並討論了經濟學.

我們可以創建一個簡短而有用的句子:

- 伊曼紐爾·馬克龍(Emmanuel Macron)在華盛頓遇到了喬·拜登(Joe Biden),並討論了經濟學.

實現這一結果是必要的幾個步驟:找到類似的句子,找到最佳的融合,檢查融合比原始句子好得多. 他們採用許多技術:Word2具有神經網絡以查找類似的句子,共同保存圖以合併它們,ILP優化以選擇最佳合併.

如果您想看到更多,Potara是開源的,但已經有一段時間沒有維護. 當我發佈時,該項目顯然是展示櫃,因此進行了文檔,測試,連續集成,PYPI部署,..

什麼是一個很好的自動摘要 ?

如果某些標準看起來很明顯且相對簡單評估(例如,句子的語法性),其他標準則更為複雜. 確定文本中最重要的信息本身已經是一項非常主觀的任務. 評估流動性,正確選擇所使用的單詞,又回到了出版工作,我們不要談論摘要可以採取的政治取向 !

基於神經網絡的新生成模型可能會引入貶義判斷或預選賽(或用戶 – 友好),這是在產生電影評論家時所尋求的效果,但在談論總統候選人計劃時,會少得多 !

因此. 在行業中,他只是開始進入非常具體的高管(例如會議摘要).

總統2022:您的數據 !

3個數據項目的示例.